近日,中国科学院合肥物质院智能所仿生智能中心陈雷团队联合上海人工智能实验室与香港中文大学,提出一种面向大模型的低秩自适应微调框架GoRA,相关论文“GoRA: Gradient-driven Adaptive Low Rank Adaptation”被国际机器学习三大顶级会议之一NeurlIPS 2025高分(Average Rating:4.50)录用。智能所硕士研究生何浩楠与香港中文大学博士后叶鹏为共同第一作者。

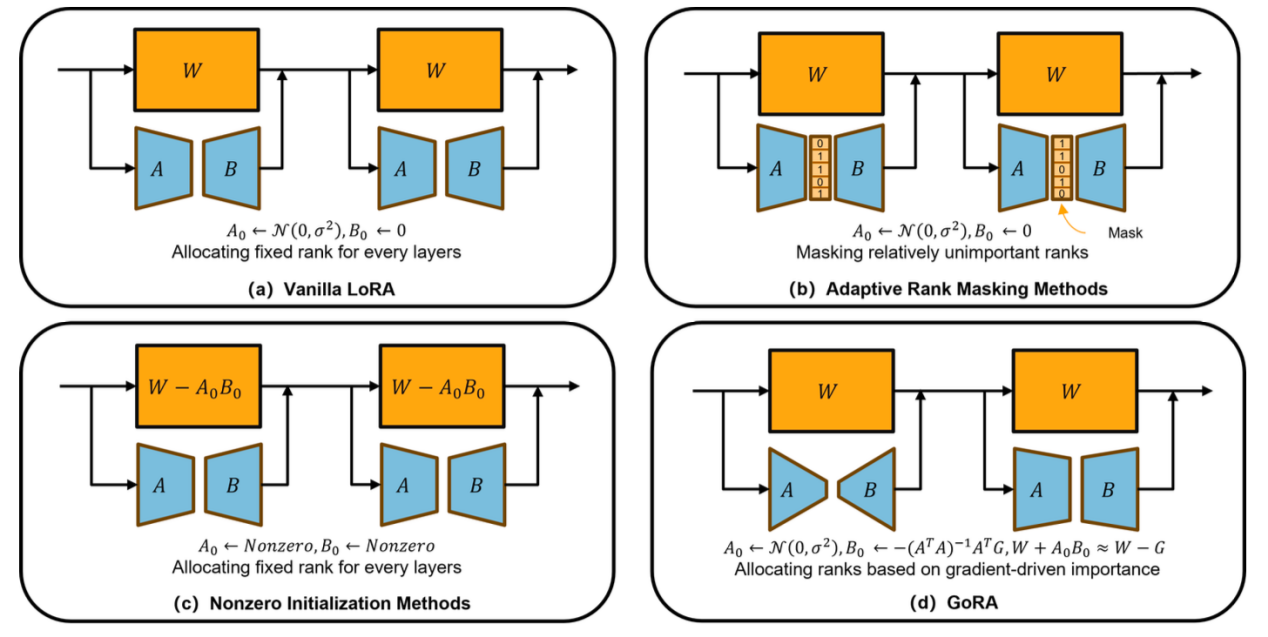

GoRA是一种全新的低秩自适应微调框架,旨在同时解决低秩微调方法LoRA中的两个关键瓶颈问题:秩的选择与权重初始化。现有方法通常仅优化其一,或在提升性能的同时牺牲效率与实用性,而GoRA创新性地利用预训练权重的梯度信息,在训练前动态分配每个适配器的最优秩,并以梯度压缩为基础对低秩矩阵进行自适应初始化。这一设计不仅避免了对原始预训练权重的修改,彻底消除了训练与推理之间的“权重不一致”问题,还显著提升了微调性能,同时几乎不增加额外的计算或内存开销。值得一提的是,GoRA保持了与标准LoRA完全兼容的结构设计,可无缝集成到现有大模型训练流程中,并支持分布式训练。其引入的自适应梯度累积与缩放因子自动调优策略,进一步降低了超参数调优负担,显著提升了方法的“开箱即用”能力。

在多项基准实验中,GoRA展现出卓越的泛化能力。在Llama3.1-8B-Base模型上进行数学推理微调时,GoRA以参考秩 r=8 的设定即超越标准LoRA达5.13个百分点(GSM8K);在更高秩设定下,其性能甚至反超全参数微调(full fine-tuning)2.05个百分点。此外,GoRA在自然语言理解(GLUE)、代码生成(HumanEval)、对话评估(MT-Bench)以及图像分类(CLIP-ViT)等多个任务和模态上均优于现有LoRA变体,验证了其跨架构、跨模态的强大适应性。

此项研究不仅为大模型高效微调提供了新范式,也为未来面向资源受限场景的轻量化模型部署开辟了新路径,具有重要的理论价值与应用前景。本研究得到国家重点研发计划与国家自然科学基金的支持。

论文链接:https://openreview.net/forum?id=d1dL1ymD6N

图1 GoRA方法与其他方法的区别