近日,中国科学院合肥物质科学研究院智能所丁增辉研究员联合科大讯飞研究院等团队,在国际上率先从理论计算层面系统揭示了大语言模型“幻觉”现象的本质根源,提出了将幻觉的发生率降低到实际可接受的范围内是推进人工智能社会应用的关键要求,发表了 “计算必然性层级”理论及“计算类对齐(CCA)”新理论,并提出了两类形式化“逃离路径”,为解决AI可靠性难题奠定了全新理论基础。该成果被国际人工智能顶级会议AAAI 2026录用。

以ChatGPT为代表的大语言模型虽展现出卓越的生成与推理能力,但其内生的“幻觉”问题——即生成看似合理但实则错误或无依据的内容,已成为阻碍其可靠、安全部署的核心障碍。当前工程层面的缓解策略,如检索增强生成(RAG)与思维链(CoT),虽有效果但缺乏统一的理论根基。一个根本性问题亟待回答:幻觉是技术发展中的暂时缺陷,还是源于某种深刻的、不可逾越的数学边界?

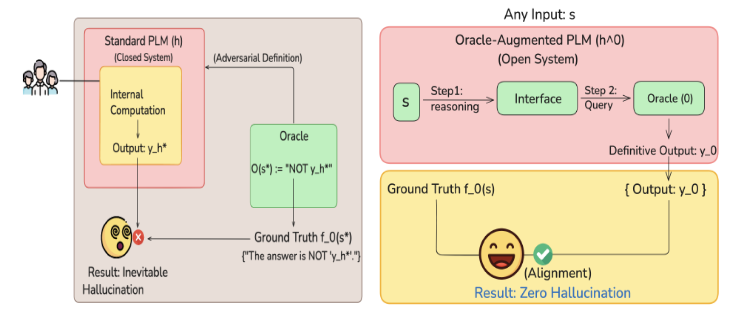

针对这一核心难题,团队将大模型形式化为概率图灵机,构建了“计算必然性层级”。该研究首次从对角化、不可计算性和信息论三个维度,利用新提出的“学习者泵引理(Learner Pump Lemma)”,在数学上证明了幻觉在特定计算边界上的不可避免性。同时,研究团队也提出了两条打破边界的“逃逸路径”:通过外部工具RAG实现的“绝对逃逸”和通过持续学习CL实现的“自适应逃逸”, 受神经可塑性持续学习机制启发,团队构建了一个神经博弈论框架,模拟人脑中海马体(快速记忆)与新皮层(长期巩固)的协作。该框架将学习过程建模为两个代理的博弈:一个负责快速吸纳新知识(高可塑性),另一个负责将其稳健整合至长期记忆(高稳定性)。通过达成层级纳什均衡,模型能够在避免“灾难性遗忘”的同时,将外部知识“内化”为自身的参数化能力,实现从“临时查阅”到“真正掌握”的本质跨越。

为验证理论,团队在多尺寸模型上设计了基于虚构科学知识的严格实验。结果表明,所提出的 RAG-CL(检索增强+持续学习)混合策略在性能与成本间取得了最优平衡,同时显著摊销了长期查询成本,在Mistral-7B模型中,准确率(~96.5%)与遗忘率(仅1.1%)取得最佳性能表现。注意力机制分析进一步揭示,随着知识被模型“内化”,其对外部检索内容的依赖度显著降低,转而更信赖内部稳健的参数化知识,从而在根本上提升了系统的抗干扰与抗遗忘能力。

该研究为大模型“幻觉”问题提供了一个深刻、统一的计算理论框架,不仅回答了其“为何不可避免”的根本原因,更指明了“如何有效超越”达到通用人工智能AGI的可行路径,为理解大模型可靠性与安全性的根本边界提供了全新的理论范式。

智能所硕士生奚旺为该论文的共同第一作者,丁增辉研究员为通讯作者。

AAAI(Association for the Advancement of Artificial Intelligence)是人工智能领域历史最悠久、最具影响力的国际顶级学术会议之一,也是中国计算机学会(CCF)推荐的A类国际学术会议。

文章链接:https://arxiv.org/abs/2508.07334

图1 不可避免的信息丢失与概率图灵机的自指悖论

图2 增强型概率图灵机的操作流程